0

SurfOffline

웹 사이트를 다운로드해야하는 경우 웹 사이트 다운로더 SurfOffline을 사용하십시오.SurfOffline을 테스트 할 수있는 30 일 무료 평가판 기간이 제공됩니다.

- 유료 앱

- Windows

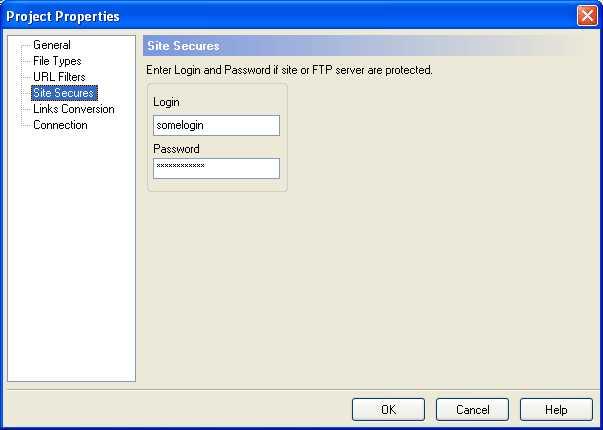

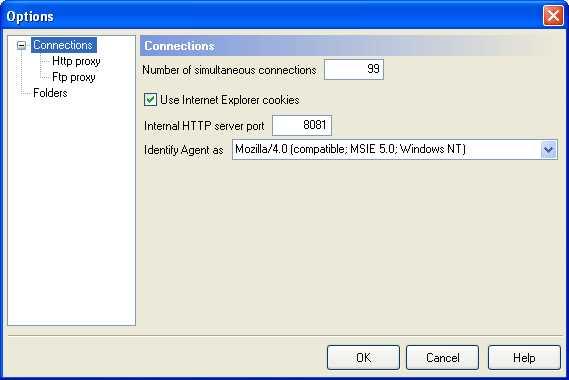

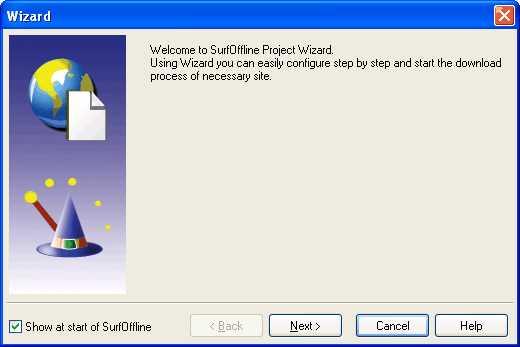

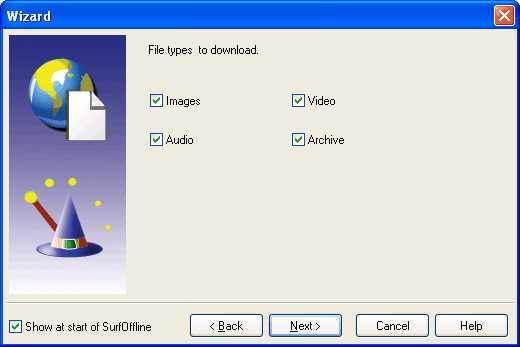

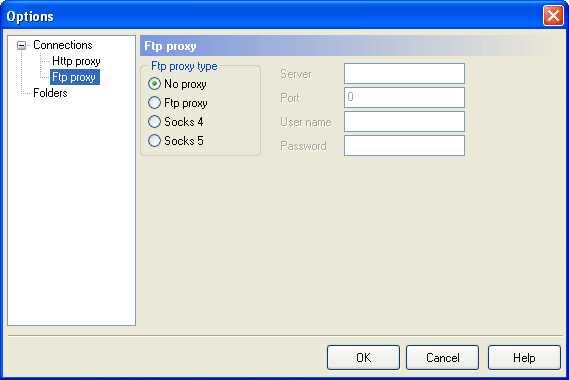

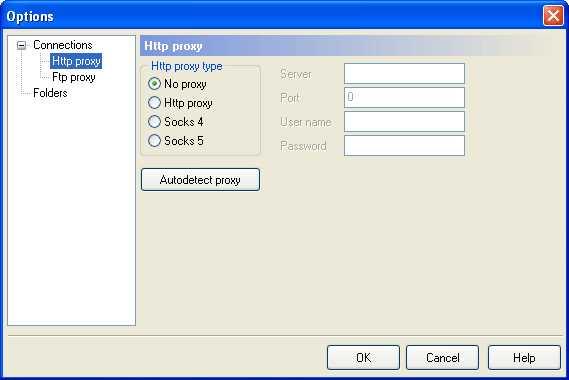

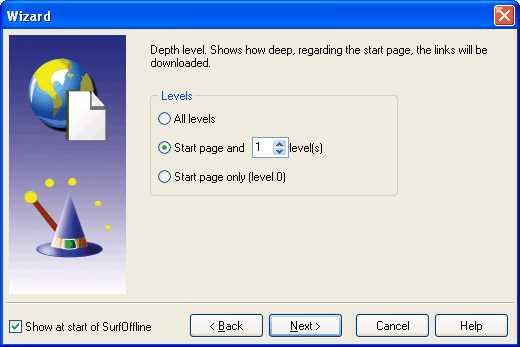

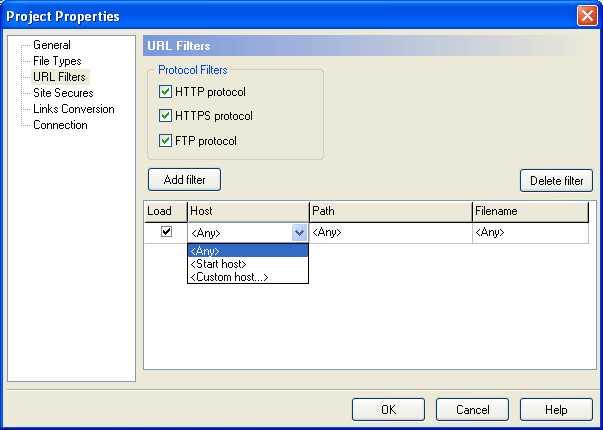

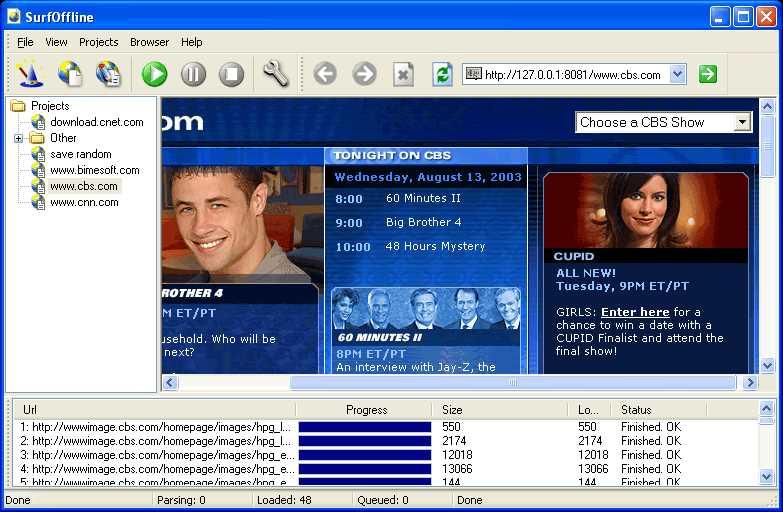

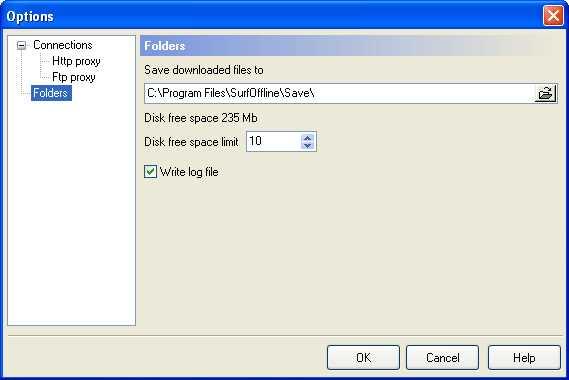

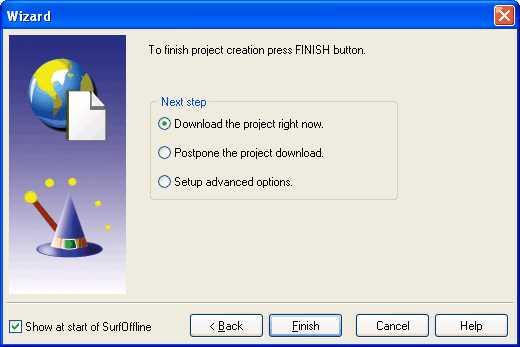

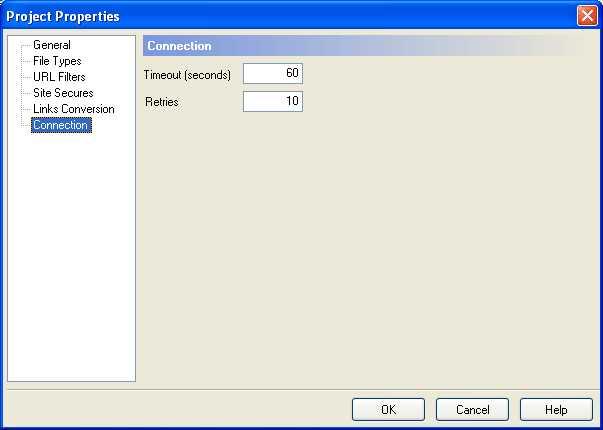

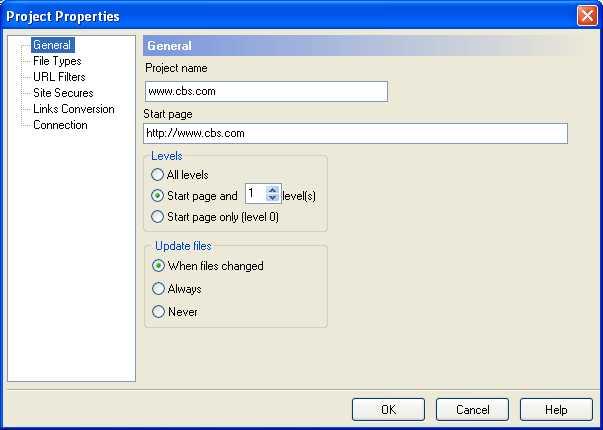

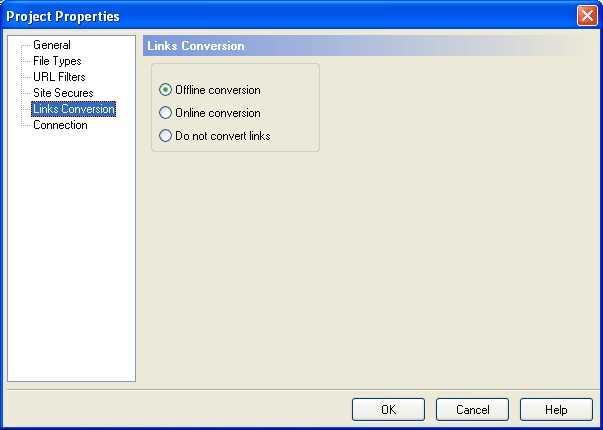

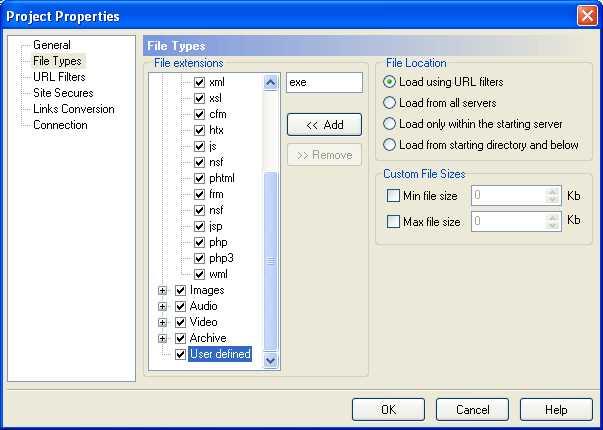

웹 사이트를 다운로드해야하는 경우 웹 사이트 다운로더 SurfOffline을 사용하십시오.SurfOffline을 테스트 할 수있는 30 일 무료 평가판 기간이 제공됩니다.SurfOffline은 빠르고 편리한 웹 사이트 다운로드 소프트웨어입니다.이 소프트웨어를 사용하면 전체 웹 사이트를 다운로드하고 웹 페이지를 로컬 하드 드라이브에 다운로드 할 수 있습니다.SurfOffline은 강력한 기능과 편리한 인터페이스를 결합합니다.SurfOffline 마법사를 사용하면 웹 사이트 다운로드 설정을 빠르게 지정할 수 있습니다.웹 사이트를 다운로드 한 후 SurfOffline을 오프라인 브라우저로 사용하여 다운로드 한 웹 페이지를 볼 수 있습니다.다른 브라우저에서 다운로드 한 웹 페이지를 보려는 경우 내보내기 마법사를 사용하십시오.또한 Surf Offline Export Wizard는 다운로드 한 웹 사이트를 다른 컴퓨터에 복사하여 나중에 볼 수 있도록하고 웹 사이트를 CD 또는 DVD로 구울 수 있도록 준비합니다.주요 프로그램 기능 * 최대 100 개 파일 동시 다운로드 * 하나의 프로젝트에서 최대 400000 개 파일 다운로드.* 전체 웹 사이트 다운로드 (이미지, 비디오, 오디오 등 포함) * CD 및 DVD에 쓸 웹 사이트 다운로드 * 비밀번호로 보호 된 웹 페이지 및 비밀번호로 보호 된 웹 사이트 다운로드 (HTTP 및 FTP 인증) * 내장 브라우저 및세션 및 쿠키 지원을 통해 웹 양식 비밀번호로 보호되는 사이트를 다운로드 할 수 있습니다.최신 인터넷 기술 지원 SurfOffline은 다음 기술을 지원하므로 대부분의 웹 사이트를 다운로드 할 수 있습니다.SurfOffline : * 주요 인터넷 프로토콜 지원 : HTTP 및 FTP * 보안 프로토콜 HTTPS (SSL)를 통해 웹 사이트 다운로드 * 프록시 서버 (HTTP, FTP 및 Socks 프록시)를 통한 연결 지원 * HTTP 및 FTP 인증 지원 * 세션 및 쿠키 지원 * 지원CSS, CSS2, Macromedia Flash 및 JavaScript 구문 분석 추가 정보 :

웹 사이트:

http://www.surfoffline.com/풍모

라이센스가있는 모든 플랫폼에서 SurfOffline를 대체

358

85

44

34

30

27

Offline Explorer

MetaProducts Offline Explorer는 Windows XP / 2003 / 2008 / Vista / 7 / 8 / 10 프로그램으로 나중에 오프라인에서 즐겨 찾는 웹 및 FTP 사이트를 무제한 다운로드 할 수 있습니다 ...

- 유료 앱

- Windows

17

SiteSucker

인터넷에서 웹 사이트를 자동으로 다운로드하는 macOS 응용 프로그램.사이트의 웹 페이지, 이미지, PDF, 스타일 시트 및 기타 파일을 로컬 하드 드라이브에 비동기식으로 복사하여 사이트의 디렉토리 구조를 복제하여이를 수행합니다.

16

14

14

PageArchiver

PageArchiver (이전의 "Scrapbook for SingleFile"이라고 함)는 오프라인에서 읽을 수 있도록 웹 페이지를 보관하는 데 도움이되는 Chrome 확장 프로그램입니다. 주요 기능은 다음과 같습니다.

12

7

WebScrapBook

고도로 사용자 정의 가능한 구성으로 웹 페이지를 충실하게 캡처하는 브라우저 확장입니다.